¿Puedo usar ChatGPT como psicólogo? Ventajas y riesgos

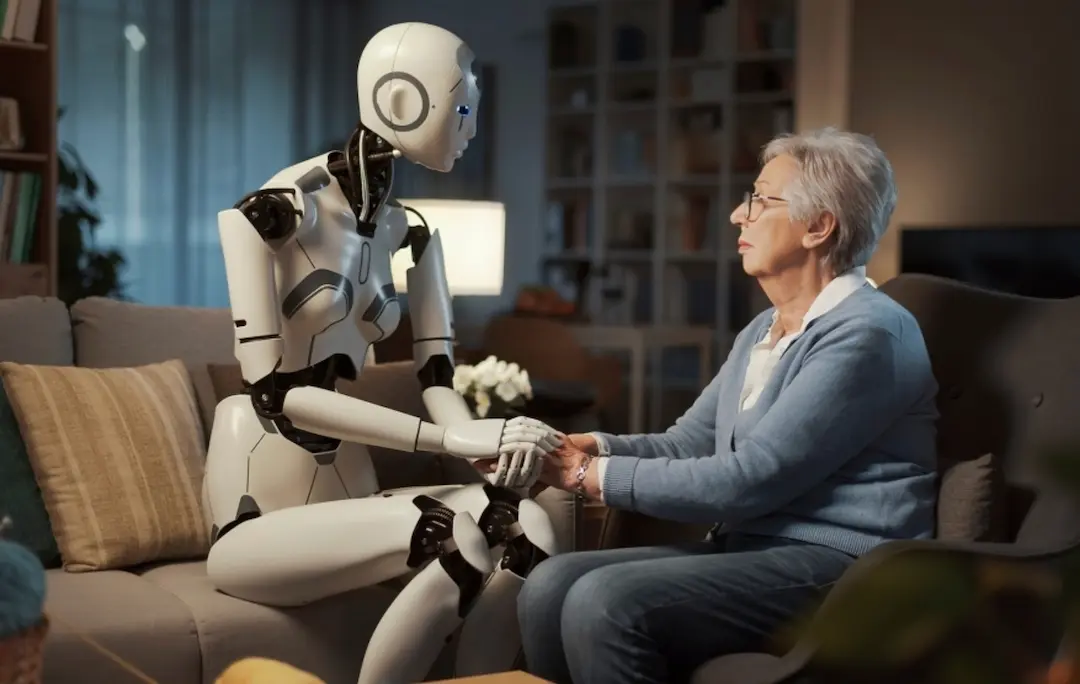

Cada vez más personas recurren a ChatGPT y otras inteligencias artificiales para hablar de sus problemas emocionales, pedir consejos o encontrar apoyo. Aunque puede parecer una opción atractiva, es importante entender que la IA no es un psicólogo real. Este artículo te explica cómo usarla de manera segura y qué riesgos puedes correr si la conviertes en tu terapeuta principal.

Lo que sí puede hacer ChatGPT por ti

- Apoyo puntual y autoexploración: puede ayudarte a ordenar ideas, reflexionar sobre tus emociones o aprender técnicas básicas de relajación, mindfulness o manejo del estrés.

- Información general: ofrece explicaciones claras sobre conceptos de psicología, ejercicios de autoayuda y estrategias sencillas para mejorar el bienestar emocional.

- Ayuda para formular preguntas: puede guiarte en cómo preparar temas para tu próxima sesión con un psicólogo humano o para entender mejor lo que te está pasando.

Bien utilizada, es una herramienta de apoyo, no un reemplazo.

Lo que NO puede hacer ChatGPT

- No diagnostica ni trata trastornos mentales.

- No ofrece intervención en crisis ni emergencias emocionales. Si tienes pensamientos suicidas, autolesiones o estás en peligro, debes buscar ayuda profesional inmediata.

- No garantiza confidencialidad ni responsabilidad ética o legal.

- No reemplaza la confrontación terapéutica real. Una IA no puede ofrecer la empatía ni el juicio clínico de un profesional humano.

El “efecto espejo” de la IA: un riesgo poco visible

Cuando hablas con una IA, en realidad interactúas con un “espejo” de tus propios pensamientos y emociones. Esto tiene ventajas, pero también puede reforzar distorsiones cognitivas si no se maneja con cuidado:

- Puede validar ideas irracionales o negativas sin cuestionarlas.

- Su tono convincente da la impresión de comprensión profunda cuando solo es un algoritmo.

- Puede fomentar dependencia emocional y alejarte de tus relaciones reales.

- Al evitar la confrontación, te impide crecer y cuestionarte.

Ejemplo: alguien con ansiedad puede preguntar “¿y si mi miedo es real?” y recibir una respuesta que refuerce ese miedo en lugar de ayudarle a relativizarlo.

Señales de que estás usando mal la IA

- Te sientes cada vez más dependiente de hablar con ChatGPT.

- Dejas de buscar apoyo humano porque “ya tienes la IA”.

- Notas que tus pensamientos negativos se refuerzan en lugar de suavizarse.

- Das por ciertas todas sus respuestas sin cuestionarlas.

Si identificas estas señales, es momento de poner límites y buscar ayuda profesional real.

Consejos para usar ChatGPT de forma segura

- Úsala solo como apoyo temporal, no como terapia principal.

- Sé específico en tus preguntas. Por ejemplo: “Dame tres formas de calmar la ansiedad ahora” en vez de “Ayúdame con mi vida”.

- Pide siempre diferentes perspectivas o pros y contras, no solo confirmación.

- Pon límites de tiempo y frecuencia. Evita la dependencia emocional.

- Acude a profesionales humanos para diagnósticos, tratamientos y problemas complejos.

- Recuerda que no hay confidencialidad profesional. No compartas datos extremadamente sensibles.

Conclusión

ChatGPT puede ser un aliado útil para reflexionar, aprender técnicas básicas y organizar tus ideas, pero no es un psicólogo ni un terapeuta. Usarlo como sustituto puede retrasar la búsqueda de ayuda profesional y agravar los problemas. Es vital mantener el pensamiento crítico al utilizarlo.

La clave está en mantener una actitud crítica, usarlo como complemento y no como reemplazo, y saber que la empatía, la confrontación terapéutica y la responsabilidad ética siguen siendo insustituibles por una IA.